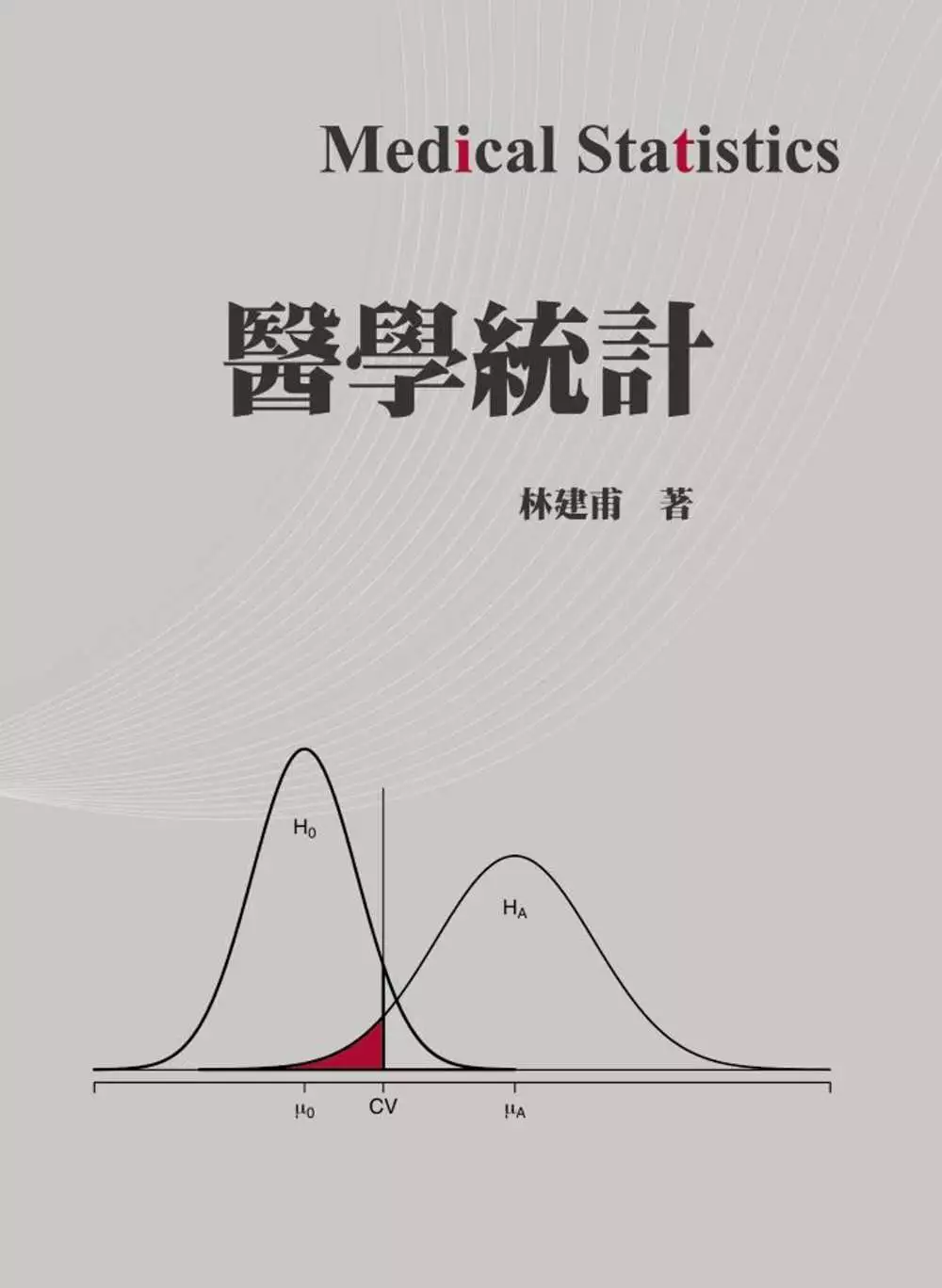

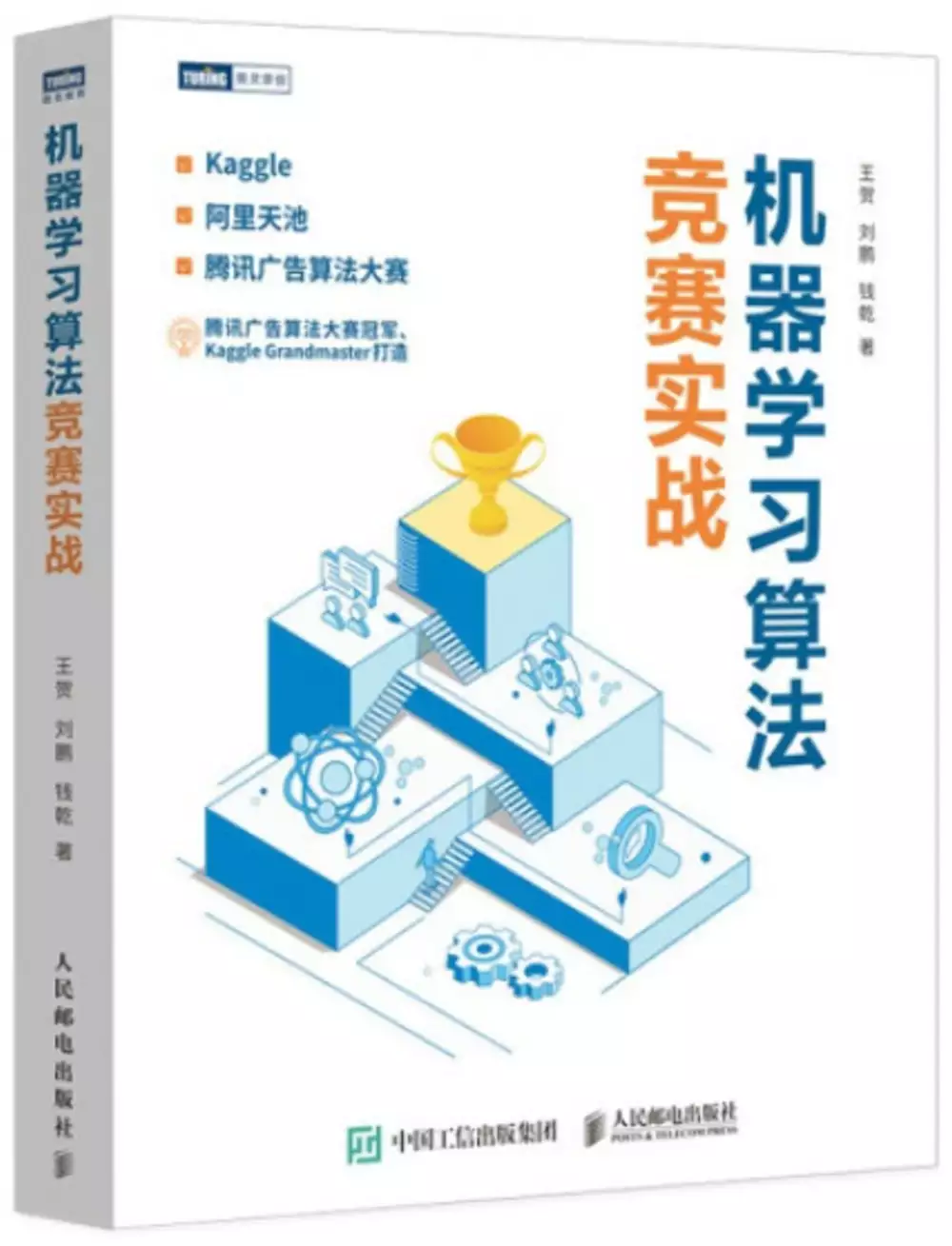

連續變數的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦林建甫寫的 醫學統計 和王賀劉鵬錢乾的 機器學習算法競賽實戰都 可以從中找到所需的評價。

另外網站量測系統連續型資料分析 - JMP也說明:量測系統連續型資料分析. 評估以連續變數為基礎之量測系統的性能。 逐步指南. 檢視指南. 在JMP 的位置. 分析> 品質與製程> Variability / Attribute Gauge Chart ...

這兩本書分別來自雙葉書廊 和人民郵電所出版 。

國立臺北大學 統計學系 須上英所指導 成玉琳的 混合型資料投影法及其於分群之應用 (2021),提出連續變數關鍵因素是什麼,來自於混合型資料、量化方法、線性判別分析、最小平方法。

而第二篇論文東吳大學 財務工程與精算數學系 张揖平所指導 丁竹松的 不平衡信用風險違約資料的處理方法比較 (2021),提出因為有 不平衡数据、信用风险的重點而找出了 連續變數的解答。

最後網站第2單元描述統計| 心理科學基礎統計則補充:連續尺度:當一筆資料內容都是數字,數值有小數點或有超過25種數值,程式都會判定為連續尺度。這類資料的數值 ... 單一自變項為連續變數, 散佈圖(scattor plot)(單元8).

醫學統計

為了解決連續變數 的問題,作者林建甫 這樣論述:

醫學統計主要討論醫學研究設計與醫學資料分析,本書以最常見的醫學研究為主軸,大約涵蓋 70% 醫學論文使用的統計方法,分成二大部分,第一部分主要是統計的基本訓練,包含常見的臨床醫學研究與醫學統計概論,第二部分是介紹常見的醫學實驗設計與中階醫學統計方法。 本書主要寫作對象為須要開始從事臨床醫學研究的醫師與研究人員,作者嘗試結合作者個人臨床醫學研究與醫學統計諮詢經驗,以醫學與統計雙方都較能了解的語言與文字,將基本的醫學研究設計與醫學資料分析方法作聯結討論,主要內容包含: 1. Probability and Exploratory Data Analysis

2. Observational Study Design and Clinical Trials 3. Common Probability Distributions and Sampling Distributions 4. Estimation and Testing Hypothesis 5. One-sample Inference and Two-sample Inference 6. Linear Regression and ANCOVA 7. ANOVA and Experimental Design 8. Contingency Table Ana

lysis and Logistic Regression 9. Event Rate and Poisson Regression 10. Survival Analysis and Longitudinal Data Analysis 11. Agreement and Consistency in Method Comparison Studies

連續變數進入發燒排行的影片

【摘要】

本影片承接上回許願池影片,講解連續變數的機率分布,包含均勻分布、指數分布、常態分布、Gamma 分布和 Beta 分布及他們的機率密度函數與期望值和變異數

【加入會員】

歡迎加入張旭老師頻道會員

付費定閱支持張旭老師,讓張旭老師能夠拍更多的教學影片

https://www.youtube.com/channel/UCxBv4eDVLoj5XlRKM4iWj9g/join

【會員等級說明】

博士等級:75 元 / 月

- 支持我們拍攝更多教學影片

- 可在 YT 影片留言處或聊天室使用專屬貼圖

- 你的 YT 名稱前面會有專屬會員徽章

- 可觀看會員專屬影片 (張旭老師真實人生挑戰、許願池影片)

- 可加入張旭老師 YT 會員專屬 DC 群

碩士等級:300 元 / 月

- 享有博士等級所有福利

- 每個月可問 6 題高中或大學的數學問題 (沒問完可累積)

學士等級:750 元 / 月

- 享有博士等級所有福利

- 每個月可問 15 題高中或大學的數學問題 (沒問完可累積)

- 可許願希望我們拍攝講解的主題 (高中、大學數學)

- 可免費參加張旭老師線上考衝班 (名額不可轉讓)

家長會等級:1600 元 / 月

- 享有博士等級所有福利

- 沒有解題服務,如需要,得另外購入點數換取服務

- 可許願希望我們拍攝講解的主題 (高中、大學數學)

- 可免費參加張旭老師線上考衝班 (名額可轉讓)

- 可參與頻道經營方案討論

- 可免費獲得張旭老師實體產品

- 可以優惠價報名參加張旭老師所舉辦之活動

股東會等級:3200 元 / 月

- 享有家長會等級所有福利

- 一樣沒有解題服務,如需要,得另外購入點數換取服務

- 本頻道要募資時擁有優先入股權

- 可加入張旭老師商業結盟

- 可參加商業結盟餐會

- 繳滿六個月成為終生會員,之後可解除自動匯款

- 終生會員只需要餐會費用即可持續參加餐會

【勘誤】

無,有任何錯誤歡迎留言告知

【習題】

無

【講義】

無

【附註】

本系列影片僅限 YouTube 會員優先觀看

非會員僅開放「單數集」影片

若想看到所有許願池影片

請加入數學老師張旭 YouTube 會員

加入會員連結 👉 https://reurl.cc/Kj3x7m

【張旭的話】

你好,我是張旭老師

這是我為本頻道會員所專門拍攝的許願池影片

如果你喜歡我的教學影片

歡迎訂閱我的頻道🔔,按讚我的影片👍

並幫我分享給更多正在學大學數學的同學們,謝謝

【學習地圖】

EP01:向量微積分重點整理 (https://youtu.be/x9Z23o_Z5sQ)

EP02:泰勒展開式說明與應用 (https://youtu.be/SByv7fMtMTY)

EP03:級數審斂法統整與習題 (https://youtu.be/qXCdZF8CV7o)

EP04:積分技巧統整 (https://youtu.be/Ioxd9eh6ogE)

EP05:極座標統整與應用 (https://youtu.be/ksy3siNDzH0)

EP06:極限嚴格定義題型 + 讀書方法分享 (https://youtu.be/9ItI09GTtNQ)

EP07:常見的一階微分方程題型及解法 (https://youtu.be/I8CJhA6COjk)

EP08:重製中

EP09:反函數定理與隱函數定理 (https://youtu.be/9CPpcIVLz7c)

EP10:多變數求極值與 Lagrange 乘子法 (https://youtu.be/XsOmQOTzdSA)

EP11:Laplace 轉換 (https://youtu.be/GZRWgcY5i6Y)

EP12:Fourier 級數與 Fourier 轉換 (https://youtu.be/85q-2nInw7Y)

EP13:換變數定理與 Jacobian 行列式 (https://youtu.be/7z4ad1I0b7o)

EP14:Cayley-Hamilton 定理 & 極小多項式 (https://youtu.be/9c-lCLV4F0M)

EP15:極限、微分和積分次序交換的條件 (https://youtu.be/QRkGLK7Iw4c)

EP16:機率密度函數 (上) (https://youtu.be/PR1NSAOP_Z0)

EP17:機率密度函數 (下) 👈 目前在這裡

持續更新中...

【版權宣告】

本影片版權為張旭 (張舜為) 老師所有

嚴禁用於任何商業用途⛔

如果有學校老師在課堂使用我的影片的話

請透過以下聯絡方式通知我讓我知道,謝謝

【張旭老師其他頻道或社群平台】

FB:https://www.facebook.com/changhsu.math

IG:https://www.instagram.com/changhsu.math

Twitch:https://www.twitch.tv/changhsu_math

Bilibili:https://space.bilibili.com/521685904

【其他贊助管道】

歐付寶:https://payment.opay.tw/Broadcaster/Donate/E1FDE508D6051EA8425A8483ED27DB5F (台灣境內用這個)

綠界:https://p.ecpay.com.tw/B3A1E (台灣境外用這個)

#連續型機率分布 #機率密度函數 #pdf

混合型資料投影法及其於分群之應用

為了解決連續變數 的問題,作者成玉琳 這樣論述:

資料分析常使用同時具有類別型變數和連續型變數的混合型資料。其中,僅有連續型變數具有可計算的「量」的概念,因此過去的分析方法以針對連續型變數為主要;類別型變數本身沒有「量」的概念,且與連續型變數的屬性不同,因此兩者常需要分別處理。由於混合型資料中的類別型與連續型變數間彼此可能有關聯,本硏究將兩種型態的變數一起投影至歐式空間。對類別變數使用線性判別分析(Linear Discriminant Analysis),對本身具有量化數值的連續變數則使用最小平方法 (Least Squares Method),找出代表每個變數的特徵向量;再以此向量,找出最適合的樣本投影位置。兩者不斷交互迭代,使樣本點投

影位置趨於穩定並收斂。這些投影位置盡可能的保留了原混合型資料的資訊,可用來量化混合型資料所描述特徵的樣本間關係。本研究使用模擬資料展現此投影方法的表現,並將其應用至實際資料的群聚分析。

機器學習算法競賽實戰

為了解決連續變數 的問題,作者王賀劉鵬錢乾 這樣論述:

本書是算法競賽領域一本系統介紹競賽的圖書,書中不僅包含競賽的基本理論知識,還結合多個方向和案例詳細闡述了競賽中的上分思路和技巧。 全書分為五部分:第一部分以算法競賽的通用流程為主,介紹競賽中各個部分的核心內容和具體工作;第二部分介紹了使用者畫像相關的問題;第三部分以時間序列預測問題為主,先講述這類問題的常見解題思路和技巧,然後分析天池平臺的全球城市計算AI 挑戰賽和Kaggle平臺的Corporación Favorita Grocery Sales Forecasting;第四部分主要介紹計算廣告的核心技術和業務,包括廣告召回、廣告排序和廣告競價,其中兩個實戰案例是2018騰訊廣告算法大

賽——相似人群拓展和Kaggle平臺的TalkingData AdTracking Fraud Detection Challenge;第五部分基於自然語言處理相關的內容進行講解,其中實戰案例是Kaggle 平臺上的經典競賽Quora Question Pairs。 本書適合從事機器學習、數據挖掘和人工智能相關算法崗位的人閱讀。 王賀(魚遇雨欲語與餘) 畢業于武漢大學電腦學院,碩士學位,研究方向為圖資料採擷,現任職於小米商業演算法部,從事應用商店廣告推薦的研究和開發。是2019年和2020年騰訊廣告演算法大賽的冠軍,從2018年至2020年多次參加國內外演算法競賽,共獲得五

次冠軍和五次亞軍。 劉鵬 2016年本科畢業于武漢大學數學基地班,保研至中國科學技術大學自動化系,碩士期間研究方向為複雜網路與機器學習,2018年起多次獲得機器學習相關競賽獎項,2019年至今就職于華為技術有限公司,任演算法工程師。 錢乾 本科就讀於美國佐治亞理工大學,研究方向包括機器學習、深度學習、自然語言處理等,現就職于數程科技,工作方向為物流領域的智慧演算法應用,任大資料技術負責人。 第 1 章 初見競賽 1 1.1 競賽平臺 2 1.1.1 Kaggle 2 1.1.2 天池 6 1.1.3 DF 7 1.1.4 DC 7 1.1.5 Kesci 7 1.1.6

JDATA 8 1.1.7 企業網站 8 1.2 競賽流程 8 1.2.1 問題建模 8 1.2.2 資料探索 9 1.2.3 特徵工程 9 1.2.4 模型訓練 9 1.2.5 模型融合 10 1.3 競賽類型 10 1.3.1 資料類型 10 1.3.2 任務類型 11 1.3.3 應用場景 11 1.4 思考練習 11 第 2 章 問題建模 12 2.1 賽題理解 12 2.1.1 業務背景 12 2.1.2 資料理解 14 2.1.3 評價指標 14 2.2 樣本選擇 20 2.2.1 主要原因 20 2.2.2 準確方法 22 2.2.3 應用場景 23 2.3 線下評估策略 2

4 2.3.1 強時序性問題 24 2.3.2 弱時序性問題 24 2.4 實戰案例 25 2.4.1 賽題理解 26 2.4.2 線下驗證 27 2.5 思考練習 28 第 3 章 資料探索 29 3.1 數據初探 29 3.1.1 分析思路 29 3.1.2 分析方法 30 3.1.3 明確目的 30 3.2 變數分析 32 3.2.1 單變數分析 33 3.2.2 多變數分析 37 3.3 模型分析 39 3.3.1 學習曲線 39 3.3.2 特徵重要性分析 40 3.3.3 誤差分析 41 3.4 思考練習 42 第 4 章 特徵工程 43 4.1 數據預處理 43 4.1.1

缺失值處理 44 4.1.2 異常值處理 45 4.1.3 優化記憶體 46 4.2 特徵變換 47 4.2.1 連續變數無量綱化 47 4.2.2 連續變數資料變換 48 4.2.3 類別特徵轉換 50 4.2.4 不規則特徵變換 50 4.3 特徵提取 51 4.3.1 類別相關的統計特徵 51 4.3.2 數值相關的統計特徵 53 4.3.3 時間特徵 53 4.3.4 多值特徵 54 4.3.5 小結 55 4.4 特徵選擇 55 4.4.1 特徵關聯性分析 55 4.4.2 特徵重要性分析 57 4.4.3 封裝方法 57 4.4.4 小結 58 4.5 實戰案例 59 4.5.1

數據預處理 59 4.5.2 特徵提取 60 4.5.3 特徵選擇 61 4.6 練習 62 第 5 章 模型選擇 63 5.1 線性模型 63 5.1.1 Lasso 回歸 63 5.1.2 Ridge 回歸 64 5.2 樹模型 64 5.2.1 隨機森林 65 5.2.2 梯度提升樹 66 5.2.3 XGBoost 67 5.2.4 LightGBM 68 5.2.5 CatBoost 69 5.2.6 模型深入對比 70 5.3 神經網路 73 5.3.1 多層感知機 74 5.3.2 卷積神經網路 75 5.3.3 迴圈神經網路 77 5.4 實戰案例 79 5.5 練習 80

第 6 章 模型融合 81 6.1 構建多樣性 81 6.1.1 特徵多樣性 81 6.1.2 樣本多樣性 82 6.1.3 模型多樣性 82 6.2 訓練過程融合 83 6.2.1 Bagging 83 6.2.2 Boosting 83 6.3 訓練結果融合 84 6.3.1 加權法 84 6.3.2 Stacking 融合 86 6.3.3 Blending 融合 87 6.4 實戰案例 88 6.5 練習 90 第 7 章 用戶畫像 91 7.1 什麼是用戶畫像 92 7.2 標籤系統 92 7.2.1 標籤分類方式 92 7.2.2 多管道獲取標籤 93 7.2.3 標籤體系框

架 94 7.3 使用者畫像資料特徵 95 7.3.1 常見的資料形式 95 7.3.2 文本挖掘演算法 97 7.3.3 神奇的嵌入表示 98 7.3.4 相似度計算方法 101 7.4 用戶畫像的應用 103 7.4.1 用戶分析 103 7.4.2 精准行銷 104 7.4.3 風控領域 105 7.5 思考練習 106 第 8 章 實戰案例:Elo Merchant Category Recommendation(Kaggle) 107 8.1 賽題理解 107 8.1.1 賽題背景 107 8.1.2 賽題數據 108 8.1.3 賽題任務 108 8.1.4 評價指標 109

8.1.5 賽題FAQ 109 8.2 探索性分析 109 8.2.1 欄位類別含義 110 8.2.2 欄位取值狀況 111 8.2.3 資料分佈差異 112 8.2.4 表格關聯關係 115 8.2.5 數據預處理 115 8.3 特徵工程 116 8.3.1 通用特徵 116 8.3.2 業務特徵 117 8.3.3 文本特徵 118 8.3.4 特徵選擇 119 8.4 模型訓練 119 8.4.1 隨機森林 119 8.4.2 LightGBM 121 8.4.3 XGBoost 124 8.5 模型融合 127 8.5.1 加權融合 127 8.5.2 Stacking 融合 1

27 8.6 高效提分 128 8.6.1 特徵優化 128 8.6.2 融合技巧 130 8.7 賽題總結 134 8.7.1 更多方案 134 8.7.2 知識點梳理 135 8.7.3 延伸學習 135 第 9 章 時間序列分析 138 9.1 介紹時間序列分析 138 9.1.1 簡單定義 138 9.1.2 常見問題 139 9.1.3 交叉驗證 140 9.1.4 基本規則方法 141 9.2 時間序列模式 142 9.2.1 趨勢性 142 9.2.2 週期性 143 9.2.3 相關性 144 9.2.4 隨機性 144 9.3 特徵提取方式 144 9.3.1 歷史平移 1

45 9.3.2 窗口統計 145 9.3.3 序列熵特徵 145 9.3.4 其他特徵 146 9.4 模型的多樣性 146 9.4.1 傳統的時序模型 147 9.4.2 樹模型 147 9.4.3 深度學習模型 148 9.5 練習 150 第 10 章 實戰案例:全球城市計算AI挑戰賽 151 10.1 賽題理解 151 10.1.1 背景介紹 152 10.1.2 賽題數據 152 10.1.3 評價指標 153 10.1.4 賽題FAQ 153 10.1.5 baseline 方案 153 10.2 探索性資料分析 157 10.2.1 數據初探 157 10.2.2 模式分析

159 10.3 特徵工程 162 10.3.1 數據預處理 162 10.3.2 強相關性特徵 163 10.3.3 趨勢性特徵 165 10.3.4 網站相關特徵 165 10.3.5 特徵強化 166 10.4 模型選擇 166 10.4.1 LightGBM 模型 167 10.4.2 時序模型 168 10.5 強化學習 170 10.5.1 時序stacking 170 10.5.2 Top 方案解析 171 10.5.3 相關賽題推薦 172 第 11 章 實戰案例-Corporación Favorita Grocery Sales Forecasting 174 11.1

賽題理解 174 11.1.1 背景介紹 174 11.1.2 賽題數據 175 11.1.3 評價指標 175 11.1.4 賽題FAQ 176 11.1.5 baseline 方案 176 11.2 探索性資料分析 181 11.2.1 數據初探 181 11.2.2 單變數分析 184 11.2.3 多變數分析 188 11.3 特徵工程 190 11.3.1 歷史平移特徵 191 11.3.2 視窗統計特徵 192 11.3.3 構造細微性多樣性 193 11.3.4 高效特徵選擇 194 11.4 模型選擇 195 11.4.1 LightGBM 模型 196 11.4.2 LST

M 模型 196 11.4.3 Wavenet 模型 198 11.4.4 模型融合 199 11.5 賽題總結 200 11.5.1 更多方案 200 11.5.2 知識點梳理 201 11.5.2 延伸學習 202 第 12 章 計算廣告 204 12.1 什麼是計算廣告 204 12.1.1 主要問題 205 12.1.2 計算廣告系統架構 205 12.2 廣告類型 207 12.2.1 合約廣告 207 12.2.2 競價廣告 207 12.2.3 程式化交易廣告 208 12.3 廣告召回 208 12.3.1 廣告召回模組 208 12.3.2 DSSM 語義召回 210 12

.4 廣告排序 211 12.4.1 點擊率預估 211 12.4.2 特徵處理 212 12.4.3 常見模型 214 12.5 廣告競價 219 12.6 小結 221 12.7 思考練習 221 第 13 章 實戰案例:2018 騰訊廣告演算法大賽——相似人群拓展 222 13.1 賽題理解 222 13.1.1 賽題背景 223 13.1.2 賽題數據 224 13.1.3 賽題任務 226 13.1.4 評價指標 226 13.1.5 賽題FAQ 227 13.2 探索性資料分析 227 13.2.1 競賽的公開資料集 227 13.2.2 訓練集與測試集 227 13.2.3 廣

告屬性 229 13.2.4 使用者資訊 229 13.2.5 資料集特徵拼接 230 13.2.6 基本建模思路 232 13.3 特徵工程 232 13.3.1 經典特徵 232 13.3.2 業務特徵 234 13.3.3 文本特徵 235 13.3.4 特徵降維 237 13.3.5 特徵存儲 238 13.4 模型訓練 238 13.4.1 LightGBM 238 13.4.2 CatBoost 238 13.4.3 XGBoost 239 13.5 模型融合 239 13.5.1 加權融合 239 13.5.2 Stacking 融合 239 13.6 賽題總結 240 13.

6.1 更多方案 240 13.6.2 知識點梳理 241 13.6.3 延伸學習 241 第 14 章 實戰案例-TalkingData AdTracking Fraud DetectionChallenge 243 14.1 賽題理解 243 14.1.1 背景介紹 243 14.1.2 賽題數據 244 14.1.3 評價指標 244 14.1.4 賽題FAQ 244 14.1.5 baseline 方案 245 14.2 探索性資料分析 247 14.2.1 數據初探 247 14.2.2 單變數分析 249 14.2.3 多變數分析 254 14.2.4 資料分佈 255 14.3

特徵工程 256 14.3.1 統計特徵 256 14.3.2 時間差特徵 257 14.3.3 排序特徵 258 14.3.4 目標編碼特徵 258 14.4 模型選擇 259 14.4.1 LR 模型 259 14.4.2 CatBoost 模型 259 14.4.3 LightGBM 模型 260 14.4.4 DeepFM 模型 261 14.5 賽題總結 264 14.5.1 更多方案 264 14.5.2 知識點梳理 265 14.5.3 延伸學習 266 第 15 章 自然語言處理 268 15.1 自然語言處理的發展歷程 268 15.2 自然語言處理的常見場景 269 1

5.2.1 分類、回歸任務 269 15.2.2 資訊檢索、文本匹配等任務 269 15.2.3 序列對序列、序列標注 269 15.2.4 機器閱讀 270 15.3 自然語言處理的常見技術 270 15.3.1 基於詞袋模型、TF-IDF.的特徵提取 270 15.3.2 N-Gram 模型 271 15.3.3 詞嵌入模型 271 15.3.5 上下文相關預訓練模型 272 15.3.6 常用的深度學習模型結構 274 15.4 練習 276 第 16 章 實戰案例:Quora QuestionPairs 277 16.1 賽題理解 277 16.1.1 賽題背景 277 16.1.2

賽題數據 278 16.1.3 賽題任務 278 16.1.4 評價指標 278 16.1.5 賽題FAQ 278 16.2 探索性資料分析 279 16.2.1 欄位類別含義 279 16.2.2 資料集基本量 279 16.2.3 文本的分佈 280 16.2.4 詞的數量與詞雲分析 282 16.2.5 基於傳統手段的文本資料預處理 284 16.2.6 基於深度學習模型的文本資料預處理 284 16.3 特徵工程 285 16.3.1 通用文本特徵 285 16.3.2 相似度特徵 287 16.3.3 詞向量的進一步應用——獨有詞匹配 290 16.3.4 詞向量的進一步應用——詞

與詞的兩兩匹配 290 16.3.5 其他相似度計算方式 291 16.4 機器學習模型和模型的訓練 291 16.4.1 TextCNN 模型 291 16.4.2 TextLSTM 模型 292 16.4.3 TextLSTM with Attention 模型 293 16.4.4 Self-Attention 層 295 16.4.5 Transformer 和BERT 類模型 296 16.4.6 基於 representation 和基於 interaction 的深度學習模型的差異 298 16.4.7 一種特殊的基於 interaction 的深度學習模型 303 16.4.8

深度學習文本資料的翻譯增強 303 16.4.9 深度學習文本資料的預處理 304 16.4.10 BERT 模型的訓練 306 16.5 模型融合 310 16.6 賽題總結 310 16.6.1 更多方案 310 16.6.2 知識點梳理 310 16.6.3 延伸學習 311

不平衡信用風險違約資料的處理方法比較

為了解決連續變數 的問題,作者丁竹松 這樣論述:

在信用風險的領域中,如何處理不平衡資料,一直是一個比較嚴重的問題,自 2008 年經濟危機以來,對於銀行而言,如何提前甄別不同類別的客戶是否違約,違約的概率有多大,違約的程度有多嚴重,這些也是極為重要的議題,也因此這是我選擇這一問題的原因。而在通常的課本教學中並不會利用到 SMOTE (Synthesized Minority Oversampling Technique)演算法,故本研究利用和鯨官網比賽資料構建一個以集成學習(Ensemble Learning)為框架,不同方法進行比較,通過預測客戶資料的未來違約的可能性的結果,比較不同方法以此展現其效果的優劣。在評價模型的成效方面,本研究

使用準確率(Accuracy)與 AUC 代表在 ROC曲線下的面積(Area Under Curve),通過參數輸入的不同以及研究不同方法來表現模型具體效果。本文有助於説明他人更好的瞭解 SMOTE 演算法,為未來做鋪墊。通過不同方法可以展現其對於不平衡資料的效果,讓他人更好的感受 XGboost(eXtreme Gradient Boosting)的全面性與成效。

連續變數的網路口碑排行榜

-

#1.在dplyr的pipe中,在mutate裡使用cut來將連續變數依據區間分塊

本來在dplyr的函數中是不支持cut函數的(cut為R base函數),但將連續變數依照特定區間分… 於 weitinglin.com -

#2.第三章.敘述統計學

算術平均值(arithmetic mean):又簡稱均值,. 為所有觀測值的總和除以觀測值的個數即為. 算術平均值,當資料是連續變數時適用。 中量(median):或稱中位數,是將資料由小. 於 www2.nsysu.edu.tw -

#3.量測系統連續型資料分析 - JMP

量測系統連續型資料分析. 評估以連續變數為基礎之量測系統的性能。 逐步指南. 檢視指南. 在JMP 的位置. 分析> 品質與製程> Variability / Attribute Gauge Chart ... 於 www.jmp.com -

#4.第2單元描述統計| 心理科學基礎統計

連續尺度:當一筆資料內容都是數字,數值有小數點或有超過25種數值,程式都會判定為連續尺度。這類資料的數值 ... 單一自變項為連續變數, 散佈圖(scattor plot)(單元8). 於 scgeeker.github.io -

#5.以梯度圖實踐三項連續變數的資料視覺化 - 盛夏不等式

本文簡介怎麼用ggplot2 套件以下圖的方式表示三項連續變數關係。 Jiao 利用這三張圖展示了林木周圍不同深度和半徑的土壤微生物多樣性 ... 於 summer-inequality.blogspot.com -

#6.以測量尺度找出適合的統計分析方法-永析統計諮詢

當自變項為「不連續」,依變項為「連續」,可採用獨立/相依t檢定、變異數分析、共變數分析等。 當自變項為「不連續」,依變項為「不連續」,可採用 ... 於 www.yongxi-stat.com -

#7.綜合離散與連續變數的分群演算法__臺灣博碩士論文知識加值系統

綜合離散與連續變數的分群演算法 · A clustering method combining categorical and numerical data · 李孟峰 · LEE, MONG-HONG · 碩士. 於 ndltd.ncl.edu.tw -

#8.Chapter 6 重要的連續機率分佈 - 海下科技研究所

高為機率值。因此,連續均勻分佈也被稱為矩形. 分佈(rectangular distribution). 185. 連續均勻分佈. 連續均勻隨機變數X 在區間上的密度函數定義如下. 於 140.117.95.8 -

#9.什麼是變數舉例說明離散變數和連續變數? - 雅瑪知識

反之,在一定區間內可以任意取值的變數叫連續變數,其數值是連續不斷的,相鄰兩個數值可作無限分割,即可取無限個數值.例如,生產零件的規格尺寸,人體測量的身高,體重, ... 於 www.yamab2b.com -

#10.統計的變數型態-類別變數 - 以斯帖統計顧問公司

而「連續變數」(Continuous variable),且分為等距變數(Interval scale)及等比變數(Ratio scale)。名義變數的數字順序只是類別的代表名稱,沒有嚴重度 ... 於 estat.pixnet.net -

#11.這7種回歸分析方法,資料分析師必須掌握! | 帆軟軟體

線性回歸是知名度最廣的建模方法之一。每當提及建立一個預測模型,它總能占一個首選項名額。對於線性回歸,它的因變數是連續的, ... 於 www.finereport.com -

#12.連續同離散變數 - Wikiwand

連續變數 (英文:continuous variable)同離散變數(英文:discrete variable)係統計學上嘅概念。一個連續變數嘅可能數值有無限咁多個,而離散變數得若干個可能數值。 於 www.wikiwand.com -

#13.第二章敘述統計(I)圖表法

本節我們將從另一種角度來. 討論變量的分類,反映對變數衡量的精確度,或是解析的程度來討論,統稱為衡. 量的尺度(scale)。 譬如,身高變數是一個連續型的變數,但它可以有 ... 於 itchen.class.kmu.edu.tw -

#14.SEM系列Part4:連續變數轉換成類別變數 - 全球量化研究網

SEM系列Part4:連續變數轉換成類別變數. 發布時間:2017/12/11 下午02:13:32. SEM Series Part 4: Convert Continuous to Categorical 影片說明:SEM系列Part4:連續 ... 於 www.papersmap.com -

#15.研究統計分析的介紹與應用(進階)

單變數邏輯. 斯迴歸分析. (Univariate. Logistic. Regression). 複邏輯斯迴. 歸分析. (Multivariate. Logistic. Regression). 可為連續或類別資料. 可為連續或類別資料. 於 www.vghtc.gov.tw -

#16.統計學裡的變項

量的變項(quantitative variable)包括等距變項和比率變項。有時,量的變項又可分為連續變項和間斷變項。 參考資料:林清山(1992)。 於 www.cyut.edu.tw -

#17.9-2-4 雙變數函數連續性的定義及例題 - 均一教育平台

影片:9-2-4 雙 變數 函數 連續 性的定義及例題,數學> 大學先修> 微積分> 逢甲大學微積分課程> 逢甲大學微積分課程-第九章偏導數。源自於:均一教育平台- 願每個孩子都 ... 於 www.junyiacademy.org -

#18.test test

其他連續隨機變數的. 例子如表5.2 所示。表中的隨機變數皆為區間值。連續隨機變數及其機率分配將於. 第6 章中討論。 評註. 決定隨機變數為離散或連續 ... 於 mail.knu.edu.tw -

#19.第六章連續型隨機變數及其常用的機率分配 - 南臺開放式課程平台

6.1 連續型隨機變數( Continuous type random variables ) · 6.2 期望值(expected value)變異數(variance) · 6.3 常態分配(normal distribution) ... 於 ocw.stust.edu.tw -

#20.離散與連續- 離散數學 - Google Sites

例如,生產零件的規格尺寸,人體測量的身高,體 重,胸圍等為連續變數,其數值只能用測量或計量的方法取得. 性質:符號x如果能夠表示對象集合S中的任意元素,就是變數。如果變數 ... 於 sites.google.com -

#21.連續變數 - A+醫學百科

在統計學中,變數按變數值是否連續可分為連續變數與離散散變數兩種.在一定區間內可以任意取值的變數叫連續變數,其數值是連續不斷的,相鄰兩個數值可作無限分割, ... 於 cht.a-hospital.com -

#22.五大變數的介紹 - 模型寶庫

在模型寶庫中,一定會探討到變數與變數之間的關係,這也是所有量化研究最 ... 干擾變數可以是類別變數(如性別、受教育程度等等),也可以是連續變數(如 ... 於 bigdatamodel.blogspot.com -

#23.第7章連續隨機變數及其常用的機率分配

統計學方法與應用. 第7章連續隨機變數及其. 常用的機率分配. 1. 熟悉並計算連續機率分配機率函數的期望值與變異數。 2. 了解常態分配的意義、特質與重要性。 於 homepage.ntu.edu.tw -

#24.空間統計分析簡介> 地理統計之定義與特性> 區域化變數之理論 ...

不同區域化變數具有不同的連續性,且此連續性乃透過相鄰點間的變異數來加以描述。在某些特殊意義或情況下,連續性是不存在的,例如:森林土壤中有效的氮含量,即使在兩 ... 於 www.supergeotek.com -

#25.應用於採取二分法顱內壓測量來預測6個月後創傷性腦損傷結果

演講題目Topic:使用連續時間馬可夫鏈作為共變數之邏輯式回歸 - 一種聯合建模方法:應用於採取二分法顱內壓測量來預測6個月後創傷性腦損傷結果A logistic regression ... 於 deoh.ncku.edu.tw -

#26.FED主席不排除連續升息全球高通膨未解 - 新唐人亞太電視台

歡迎回來,6月28號,在歐洲央行年度會議上,全球主要央行領導人一致認為,可以在避免陷入經濟衰退的情況下,進一步收緊政策以對抗高通膨。 於 www.ntdtv.com.tw -

#27.SEM實務性的應用- 中介與干擾效果的驗證

換比較差異顯著性,. 顯著即有干擾效果. 兩個變數有交互作用的. 變異數分析(ANOVA),. 交互作用即干擾效果。 類別. 連續. 類別. 自變項(X). 干擾變項. (M) ... 於 necis.nhu.edu.tw -

#28.表格的分析與解釋

X: 連續變數(⾝身⾼高、︑、體重、︑、⾎血壓...)、︑、類別變數. (性別、︑、教育程度、︑、居住地...) Y = B0 + B1X1 + B2X2 + … + BkXk + e. 於 www3.stat.sinica.edu.tw -

#29.Random Number Generator - 不重複隨機亂數產生器

不重複隨機亂數產生器,可用於抽獎或是大冒險唷! 連續數字. 貼上字串. 從 到 選 個數字. 選 個字串. 隨機產生. LEAVE COMMENTS. 於 lab.25sprout.com -

#30.用哪種統計分析方式好?(卡方,Anova,T-test, or regression?)

如果是連續變數,也可以設一個標準,多少以上是好的,以下是差的,以此來產生類別變數。 如果超過兩組,必須用Anova來分析。 另外,常犯的錯就是把前、後 ... 於 researcher20.com -

#31.R ggplot2 各類型繪圖 - HackMD

ggplot2 繪圖各論## 2. 不同類型圖形的繪製在決定採用何種圖之前,必須要了解資料的變數屬性,像是有幾個變數需要呈現、資料類型屬於連續變數(continuous variable. 於 hackmd.io -

#32.隨機變數X 分成兩類: (a)離散型(可能值為有限個或可數無限個 ...

,Var(X)= E(X2)- [E(X)]2 。 (b) 連續型隨機變數之機率密度函數(probability density function)為 f( )(不是代表P( ... 於 stat.site.nthu.edu.tw -

#33.連續變數 - 華人百科

在統計學中,變數按變數值是否連續可分為連續變數與離散變數兩種。在一定區間內可以任意取值的變數叫連續變數,其數值是連續不斷的,相鄰兩個數值可作無限分割, ... 於 www.itsfun.com.tw -

#34.7 連續隨機變數及其常用的機率分配

7 連續隨機變數及其常用的機率分配. 學習目的. 1. 熟悉並計算連續機率分配機率函數的期望值與變異數。 2. 了解常態分配的意義、特質與重要性。 3. 了解標準常態分配的 ... 於 mail.tku.edu.tw -

#35.資料視覺化(v3.0) - RPubs

例如我們有一筆資料,其中有兩個連續變數,我們可以用散佈圖來檢視:. with(anscombe, plot(x1, y1, pch=16, cex=2, col='blue', xlab='X', ylab='Y', ... 於 rpubs.com -

#36.干擾變數增多7月震盪加劇- 工商時報

此次舉行的年度央行論壇討論焦點都放在通膨,美國聯準會(Fed)主席鮑爾在年度央行論壇上,重申今年底前將繼續升息,且表示他不會「完全」排除連續升 ... 於 ctee.com.tw -

#37.常用25種統計方法

迴歸 (路徑)分析. (多變量)變異數分析. 偏最小平方迴歸. 類別變數. 連續變數 ... 不連續. Y(依變數). 卡方分析. 敘述統計. 區別分析. 羅吉斯分析. 迴歸分析. 於 webftp.nkut.edu.tw -

#38.那個才是影響依變項最多的自變項?以SPSS實作解釋型多元 ...

「方法」選擇「輸入」,也就是「強迫進入變數法」。 ... 這是因為多元迴歸分析就是以連續變項預測連續變項的分析方法,所以必須將資料全部轉換成連續 ... 於 blog.pulipuli.info -

#39.lirz1.tpf-1 3/29/2007 15:09:56

連續變數 (continuous variable)可以有無數個不同之值,任何兩個值. 之間都可以加以無限制的細分。時間、年齡、身高、體重、智商等都是連. 續變數。我們測量連續變數所 ... 於 www.wunan.com.tw -

#40.新北Q1預售屋實登出爐這區交易最夯 - 591新聞

其中三重區申報件數838件、成交總金額157.5億元,皆為全市之冠,且已連續兩季奪冠。新北市政府地政局地價科科長蕭湘君表示,分析交易熱絡行政區,如中 ... 於 news.591.com.tw -

#41.連續變數離散變數到底怎麼分|變數判斷小訣竅 - YouTube

Lec07 統計學(一)(基礎統計) Ch5-1 隨機 變數 及離散型機率分佈Discrete Random Variables and the Discrete Probability Dist... NYCU OCW. NYCU OCW. 於 www.youtube.com -

#42.連續變數 - 中文百科知識

自變數和因變數皆為連續變數。相關比(correlation ratio):衡量兩個連續變數之相關性。Gamma相關係數:衡量兩個次序尺度變數...是真正名目尺度二分變數。Y變數是連續 ... 於 www.easyatm.com.tw -

#43.統計方法與應用 - 中國醫藥大學圖書館

理解各變數的類型:判斷某些連續型變數是否 ... 單一變數的描述性統計(個數(%)、平均值、標 ... 調整多個變數的分析(multivariate analysis) (過. 於 lib.cmu.edu.tw -

#44.國立政治大學商學院統計學研究所

的關聯性。而關聯性分成兩種,相似程度(similarity)和不相似程度(距離)(dissimilarity, distance),無論是哪種關聯性,在計算連續型變數之關聯性時,已經有許多不錯且. 於 nccur.lib.nccu.edu.tw -

#45.隨機變數

皆是離散型隨機變數。而第二種就是連續型隨機變數(continuous random variable) , 此取值在某一區間或. 區間集合的所有數值, 如重量、時間、溫度等。 於 www.stat.nuk.edu.tw -

#46.共變數與其財務上應用- 徐晣彧的學習平台

上課筆記. 課本研讀摘錄. 不連續變項的機率分配(新課本p191). discrete variable 間斷(離散). Recall:. 數值變數分為連續與不連續,不連續的變數是 ... 於 si.secda.info -

#47.25種統計方法秘技(I)

認識統計方法. X自變數. Y依變數. 連續. 不連續. 連續. 不連續. 敘述統計. 卡方分析. 區別分析. Logistics. T檢定. ANOVA. MANOVA. 相關分析迴歸分析. 路徑分析. 於 www.iem.yuntech.edu.tw -

#48.具連續變數之調節複迴歸的樣本數決定 - 國立交通大學機構典藏

標題: 具連續變數之調節複迴歸的樣本數決定. Sample Size Determinations for Moderated Multiple Regression with Continuous Variables. 作者: 謝國文 於 ir.nctu.edu.tw -

#49.連續型隨機變數的期望值與標準差

Page 1. 連續型隨機變數的期望值與標準差—自我檢測解答. 1. (4). 2. (1). 3. (4). 4. (4). 5. (3) 於 courses.openedu.tw -

#50.如何運用SAS EM 進行變數篩選(上) - SAS Taiwan

連續變數 類別化(Number of Bins) — 將連續變數進行資料級距切割,已進行卡方分析,預設值為50。 Variable Selection node 變數篩選方法. Variable ... 於 blogs.sas.com -

#51.什么是类别、离散和连续变量? - Support - Minitab

定量变量可以分为离散变量和连续变量。 类别变量: 类别变量包含有限的类别数或可区分组数。类别数据可能不是逻辑顺序。例如,类别变量包括性别、材料类型和付款方式。 於 support.minitab.com -

#52.統計學系列課程-07-06 變數變換(連續型) - 李柏堅 - Facebook

李柏堅老師今天介紹"07-06 變數 變換( 連續 型)",有興趣的同學可以觀看! 於 www.facebook.com -

#53.企業景氣展望連續8個季度告“負”……要果斷解除投資枷鎖

如果下半年房地產市場出現逆全租難等問題,目前還算不錯的消費心理再次萎縮的可能性也不小。 改變這種情況的變數只有企業的投資。但在全國經濟人聯合會的 ... 於 www.donga.com -

#54.統計力學(59):第二十九章連續對稱模型

所謂對稱,即是把某些變數改了,而 H 不變。例如把坐標方向改了,向量模型的能量不變,把坐標平移,原子間作用能不變,把液面整個上 ... 於 hongruma.net -

#55.操盤心法-干擾變數增多7月震盪加劇 - 旺得富理財網

此次舉行的年度央行論壇討論焦點都放在通膨,美國聯準會(Fed)主席鮑爾在年度央行論壇上,重申今年底前將繼續升息,且表示他不會「完全」排除連續升 ... 於 wantrich.chinatimes.com -

#56.遇到同時有連續型及類別型變數的情況會如何做資料前處理?若 ...

遇到同時有連續型及類別型變數的情況會如何做資料前處理?若要使用年齡來比較變數重要性,利用類別編碼進行轉換,適合randomforestclassifier去做分析嗎 ... 助教您好:. 在 ... 於 www.cupoy.com -

#57.8 探索性資料分析| R 學習筆記 - Bookdown

如果是連續變數,例如數字與日期時間,我們則要使用histogram,如:. # binwidth 引數即直方圖的直方寬度 ggplot(data = diamonds) + geom_histogram(mapping = aes(x ... 於 bookdown.org -

#58.機率與統計單元二Properties of Variable

統計分析是否適用於某一特定的變數,需考量變數資料是定性﹙質;qualitative﹚或定量﹙ ... 連續與不連續變數 ... 連續﹚. example1:身高、體重、溫度物理基本單位。 於 www.pws.stu.edu.tw -

#59.「這時」進場好過明年坐地起價?專家曝:房市沒有任何回溫可能

歷經去年至今央行連續多次升息、政府打炒房政策抑制,以及景氣下行等因素, ... 再升息抗通膨的變數,加上政經情勢依舊不穩,對於房市都算雪上加霜。 於 news.housefun.com.tw -

#60.第一章敘述統計...................................................001

三、測量尺度種類,S.S.Stevens 將測量尺度依不同變數的特性,分成以. 下四種變數 ... 次序變項(Ordinal Variable):又稱順序變項,通常為不連續變. 於 www.sir.com.tw -

#61.連續隨機變數連續變數:時間、分數、重量 - SlidePlayer

討論連續隨機變數的機率時,所討論的機率是某一段區間或某一塊區域的機率,如: ... 3 9.1 連續分配直方圖→ 連續曲線→ 機率密度函數(probability density function) 於 slideplayer.com -

#62.第十章相關分析(Correlation Analysis)

熟習雙變數簡單相關分析 ... 兩個連續變項的關聯情形,除了用散佈圖的方式來表達,尚須建 ... 關係數要能反應兩個變數的配對觀察值的分佈,其運算必須考慮. 於 scholar.fju.edu.tw -

#63.公共衛生核心課程基本能力測驗102 年生物統計考試試卷

16. 對兩個連續變數而言,皮爾森相關係數(r)與簡單線性迴歸係數(b)之關. 係是? (A) r. 2×b2. =1. (B) r 愈小,b 愈 ... 於 www.publichealth.org.tw -

#64.Fed不排除連續升息、蔣尚義掌舵訊芯-KY、美光低谷已過本周 ...

美國聯準會主席鮑爾本周出席論壇除重申鷹派立場外,也指出不排除連續升息,前台積大將蔣尚義本周新任訊芯- KY 董事長,引發業界關注,記憶體大廠美光 ... 於 news.cnyes.com -

#65.操盤心法-干擾變數增多7月震盪加劇

... 美國聯準會(Fed)主席鮑爾在年度央行論壇上,重申今年底前將繼續升息,且表示他不會「完全」排除連續升息的可能性,保留7月調高利率的機率。 於 tw.stock.yahoo.com -

#66.連續變數:定義,性質,對比,離散變數,類別變數 - 中文百科全書

在一定區間內可以任意取值的變數叫連續變數,其數值是連續不斷的,相鄰兩個數值可作無限分割,即可取無限個數值。例如,生產零件的規格尺寸,人體測量的身高、體重、胸圍等 ... 於 www.newton.com.tw -

#67.定量變數

變數. 定性. 定量. 不連續. 連續. 2. 變數的類型(Types of variable). 資料或變數可以分成兩類:. 定性變數(qualitative variable). 或稱為類別變數(categorical ... 於 lochichilo.weebly.com -

#68.內科部研究能力課程(二) 連續型變數之統計檢定

平均數的比較,其基本假設是數據呈現常態. 分布。 ○在資料分析前應要先做常態分佈的檢定,確. 認連續變數是否可採用平均數檢定 ... 於 sub.chimei.org.tw -

#69.連續型隨機變數- 教育統計學 - 首頁- Camdemy

7 連續型隨機變數. Uploaded by 李政軒on 2013-07-19. 附件. 長度: 24:12, 發表時間: 2016-03-10 07:52. 觀看次數: 1,520. 於 u.camdemy.com -

#70.連續變數 - MBA智库百科

連續變數 (continuous variable)在統計學中,變數按變數值是否連續可分為連續變數與離散變數兩種.在一定區間內可以任意取值的變數叫連續變數,其數值是連續不斷的, ... 於 wiki.mbalib.com -

#71.[問題] 連續變數跟間斷變數? - 看板Statistics - 批踢踢實業坊

... 相關的課所以對某些定義跟名詞不是很清楚最近看到次數分配表的建立有一個步驟是決定上下限可是要看變數是連續變數或是間斷變數因為2者的分組分式不同. 於 www.ptt.cc -

#72.連續同離散變數 - 維基百科

連續變數 (英文:continuous variable)同離散變數(英文:discrete variable)係統計學上嘅概念。一個連續變數嘅可能數值有無限咁多個,而離散變數得若干個可能數值。 於 zh-yue.wikipedia.org -

#73.三分鐘搞懂變項與量尺 - 五餅老師x統計客

間斷變項(discrete variable):變項的數值不能分割,只能以一種特定數值來表示。因此,間斷變數的一個值只能代表一個點,而不是一段距離。 · 連續變項( ... 於 we147121.pixnet.net -

#74.變數Variables - 雙語詞彙- 國家教育研究院

沒有這個頁面的資訊。 於 terms.naer.edu.tw -

#75.下面哪一個變項不是屬於連續變數? (A)解決問題所花費的時間(B ...

... 以得到無限多個介於兩者之間大小不同的值,具有此類特質或屬性之變數,稱為連續變數。 ... (A)時間--->比率變數 (B) 溫度-----> 等距變數 (C) 高度---> 比率變數. 於 yamol.tw -

#76.景氣燈號第7顆藍燈國發會:成長動能偏低| 中廣新聞網

... 月景氣對策信號,再度亮出代表景氣低迷的藍燈,是連續第7顆藍燈。 ... 至於影響景氣的變數則是全球主要央行升息的遞延效應,還有地緣政治等不確定 ... 於 today.line.me -

#77.各項統計方法的使用目的及使用時機

使用時機:適用於兩個連續變數。 例子:同一組人其智力和學業成績之間的相關。 2.獨立樣本t 考驗(t-test, independent samples). 使用目的:兩個平均數的差異考驗。 於 physical.ntsu.edu.tw -

#78.控制通膨Fed主席:不排除未來數月連續升息 - 經濟日報

美國聯邦準備理事會(Fed)主席鮑爾(Jerome Powell)今天表示,聯準會對未來幾個月持續升息的可能性維持開放態... 於 money.udn.com -

#79.研究設計與統計方法 - 長庚醫院

一個連續的依變數和三個類別的自變數(main effect? interactions??) ▫. SPSS 分析一般線性模式(general linear model, GLM. GLM) 單變量( ... 於 www1.cgmh.org.tw -

#80.淺談變數獨立性 - Empirical Filtration

這次我們來談談隨機變數的獨立性(independence) 假設今天有兩個隨機變數: ... 當今天變數是連續變數時問題就比較複雜一些但如果我們假設X,Y是常態分配 ... 於 yenchic-blog.logdown.com -

#81.連續變項vs. 間斷變項 - Dr. Fish 漫游社會統計

連續 變項指相鄰的測量單位間存在著無限的數值,例如重量、身高、時間、年齡,等距和比率測量尺度的變項即屬於連續變項的範疇。例如身高的測量,身高150 ... 於 drfishstats.com -

#82.統計學準備要領:第3章單變量隨機變數-高點研究所

而在計算連續型隨機變數動差時,會用到積分的性質。對於積分較不擅長或者對於數學感到恐懼的同學,也不太需要害怕此章。因為大多數的積分以冪函數與 ... 於 master.get.com.tw -

#83.一般連續變數通常是就直接進演算法內。 離散 ... - Tommy Huang

一般連續變數通常是就直接進演算法內。 離散變數(類別)還要先經過前處理: 類別變數編碼(Categorical Feature Encoding)→ "one-hot encoding"或 ... 於 chih-sheng-huang821.medium.com -

#84.社會科學統計方法

6 兩個連續變數; 7 交互作用. 7.1 交互作用原理; 7.2 用Anova測試交互作用是否顯著; 7.3 範例:工黨得票率的迴歸模型. 8 R2與F檢定. 於 rstudio-pubs-static.s3.amazonaws.com -

#85.變項(Variable) @ 閱讀與生活 - 隨意窩

... 一為自變項(independent variable),一為依變項(dependent variable)。 二、其他有關名詞解釋○連續變項(continuous variable):對@ 教育行政,旅遊,親子@ kc6191. 於 blog.xuite.net -

#86.定義連續變數- 2012 - SOLIDWORKS 說明

您可以透過定義連續變數來執行最佳化。您不能使用連續變數執行評估設計研究。連續變數表示介於最小值與最大值之間的任何值(整數、有理數及無理數)。 於 help.solidworks.com -

#87.為什麼要把連續型變數離散化 - iT 邦幫忙

Day13 Converting Continuous Variables into Discrete Values 連續型變數離散化. Hands on Data Cleaning and Scraping 資料清理與爬蟲實作系列第13 篇. 於 ithelp.ithome.com.tw -

#88.連續型機率分配

機變數,大都是連續的隨機變數。這些連續的隨機變. 數具有共同的特性,其機率分配的形態很類似。例如. :人的身高,大部分的人都很接近而且集中在平均身. 於 rs2.ocu.edu.tw -

#89.雙變數分析IIQ1輔助說明及範例

在進行分析前,須先了解依變數的類型方可選擇適當的統計方法,若依變數為連續型變數,適合以簡單迴歸分析(simple regression analysis)來分析;若依變數為類別型變數, ... 於 rweb.tmu.edu.tw -

#90.SUMIFS、SUMPRODUCT、3D SUM,5 大公式用法 - 經理人

Excel教學|SUM、SUMIF、SUMIFS、SUMPRODUCT、3D SUM,5 個必學的Excel 加總函數用法,快速提升工作效率! 於 www.managertoday.com.tw -

#91.單元25: 連續隨機變數的期望值

定理4.4. 設連續隨機變數Y ∼ f(y) (pdf), 且 g(Y ) 為Y 的函數, 則. E[g(Y )] = ∫ ∞. −∞ g(y)f(y)dy. 1. 中大數學系:振華 ... 於 www.math.ncu.edu.tw -

#92.什麼是變數,舉例說明離散變數和連續變數? - 劇多

連續變數 與離散變數的簡單區別方法:連續變數是一直疊加上去的,增長量可以劃分為固定的單位,即:1,2,3…… 例如:一個人的身高,他首先長到1.51,然後才能 ... 於 www.juduo.cc -

#93.連續機率分配

正因為如此,我們僅可以決定一個範圍內數值的機率。 例,一個離散(不連續) 的隨機變數,譬如說投擲一個骰子,. P(X=5)是有意義 ... 於 web.ntpu.edu.tw -

#94.BMJ統計小小問題(1):評估兩個連續性變項線性相關程度 - 方格子

BMJ 統計問題(1):評估兩個連續變項線性相關程度最適合的分析方式為何? ... 散佈圖:以圖形方式顯示兩個連續變數之間的關聯。x軸顯示一個變數的 ... 於 vocus.cc -

#95.【謝章升專欄】SPSS多變量方法那麼多,我怎麼知道自己要用哪 ...

請問課程有提到SPSS多變量中弄懂連續變數或不連續變數. 就能分清楚要用哪些多變量方法. 判別連續與不連續,只要看平均數是沒否有意義,那意義是指什麼 ... 於 www.tutortristar.com -

#96.06 連續性機率分布

在連續機率分布中,隨機變數X 機率數值,以機率函數f(x)表示,亦可稱為機率密度函數(probability density function)。 在連續機率分布中,若隨機變數X在某一特定區間內 ... 於 www2.nkust.edu.tw -

#97.多項式羅吉斯迴歸 - IBM

因變數必須是類別的。而自變數則可以是因素或共變量。一般而言,因素應該是類別變數,而共變量應該是連續變數。 於 www.ibm.com