視訊鏡頭的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦蔡文瑞,魏與晟,陳昌偉,王明智,王盈彬寫的 往 / 返 / 第二空間:網路與精神分析 和施威銘研究室的 Flag’s 創客‧自造者工作坊 用 AI 影像辨識學機器學習都 可以從中找到所需的評價。

另外網站請益居家工作視訊鏡頭開啟也說明:最近找工作傾向WFH,有一份居家工作的要求上面寫著:遠距辦公連線時,要保持視訊鏡頭開啟,這樣公司的人會隨時看有沒有在辦公嗎?

這兩本書分別來自無境文化 和旗標所出版 。

國立臺北科技大學 電子工程系 黃士嘉所指導 陳哲偉的 基於原生架構設計與實現應用WebRTC的即時多媒體通訊 (2021),提出視訊鏡頭關鍵因素是什麼,來自於WebRTC、多媒體即時通訊、原生架構。

而第二篇論文國立彰化師範大學 電機工程學系 魏忠必所指導 吳振豪的 應用影像辨識技術於PU滾輪灌注瑕疵檢測之研究 (2021),提出因為有 PU 滾輪、YOLOv4-tiny、分類模型、氣泡瑕疵的重點而找出了 視訊鏡頭的解答。

最後網站視訊鏡頭Webcam丨視訊會議必備則補充:WFH視訊會議必備,高畫質1080P讓你會議品質最高提升,智選家嚴選品牌EMEET、AnkerWork..等,幫助你在視訊會議WFH都順利穩定。具備自動對焦、定焦功能,超廣角FOV視場 ...

往 / 返 / 第二空間:網路與精神分析

為了解決視訊鏡頭 的問題,作者蔡文瑞,魏與晟,陳昌偉,王明智,王盈彬 這樣論述:

★漫遊無限網路空間,是什麼讓人流連忘返 ? ★失落中誕生的網路宅文化 ★防衛不再是心理操作,而是滑一下就可付諸的真實行動 ★網路之中,我們更近了,還是更遠了? 在網路興起的時代,限制我們身體的時空似乎某種意義上被打開新的想像。於是,我們可以在任意一處與橫越大洋他處的人對話與互動。聲音與影像的留置,我們可以輕易回到過往那早早已經過去的時空,甚至,跨越到我們現實無從經驗的世界。更有甚者,在網路的世界裡,各種虛擬與仿生,把不可能變成可能,經常都挑戰著我們想像的極限。 時間、空間是精神分析中非常重要的現實要素。 無論我們如何自由地放任心靈進行聯想,

跨越時空,我們仍不免回到最終的現實,回到身處的治療室,一個只有治療者與個案兩人的時空當下。相反的,即使有著現實肉身的限制,治療室卻無法禁錮我們的心靈,穿越過去、現在與未來,此地或是他處,我們在這裡,但又不在這裡。 從精神分析出發,我們不僅僅是想討論現實操作的「通訊治療」,更希望透過想像,一起透析網路世界以及時空與身體的邊界,甚至一起探索關於存在的可能性。

視訊鏡頭進入發燒排行的影片

--加入: https://www.youtube.com/channel/UC7iIGOn477JNYG7WcNDmStw/join

--粉專: https://www.facebook.com/Sowhaner/

--實況: https://www.twitch.tv/sowhan/

--IG: https://www.instagram.com/sowhan_q/

--discord: https://discord.gg/EbAKDVC

搜憨商業聯絡: [email protected]

設備:

麥克風: https://amzn.to/2nzWSNE

視訊鏡頭: https://amzn.to/2nBTTUJ

滑鼠: https://amzn.to/2KReaPz

鍵盤: https://amzn.to/2vKB1Yd

耳機: https://amzn.to/2Pcg28U

基於原生架構設計與實現應用WebRTC的即時多媒體通訊

為了解決視訊鏡頭 的問題,作者陳哲偉 這樣論述:

自2020年起,全世界都飽受COVID-19所苦,新冠肺炎的高度傳染性對於現今社會造成極大的衝擊。公司員工每週定期面對面匯報工作進度的晨會被迫中止,遠端通訊媒體如雨後春筍般地湧現, Google Meet、Microsoft Teams 和 Zoom 等各種應用了 WebRTC 的通信應用如雨後春筍般湧現,皆旨在為疫情時代找出讓生活重回正軌的方法。WebRTC,全稱為Web Real-Time Connection,是一種藉由點對點的UDP來傳送串流資料的架構,它能夠通過應用程序介面來為行動裝置提供即時通信,並以具有相當低的延遲而聞名。而以原生的架構實現則可以讓其對裝置的控制力最大化。本論文

提出一種基於原生架構設計與實現應用WebRTC的即時多媒體通訊,冀望能為後疫情時代重建中的秩序盡一份心力。

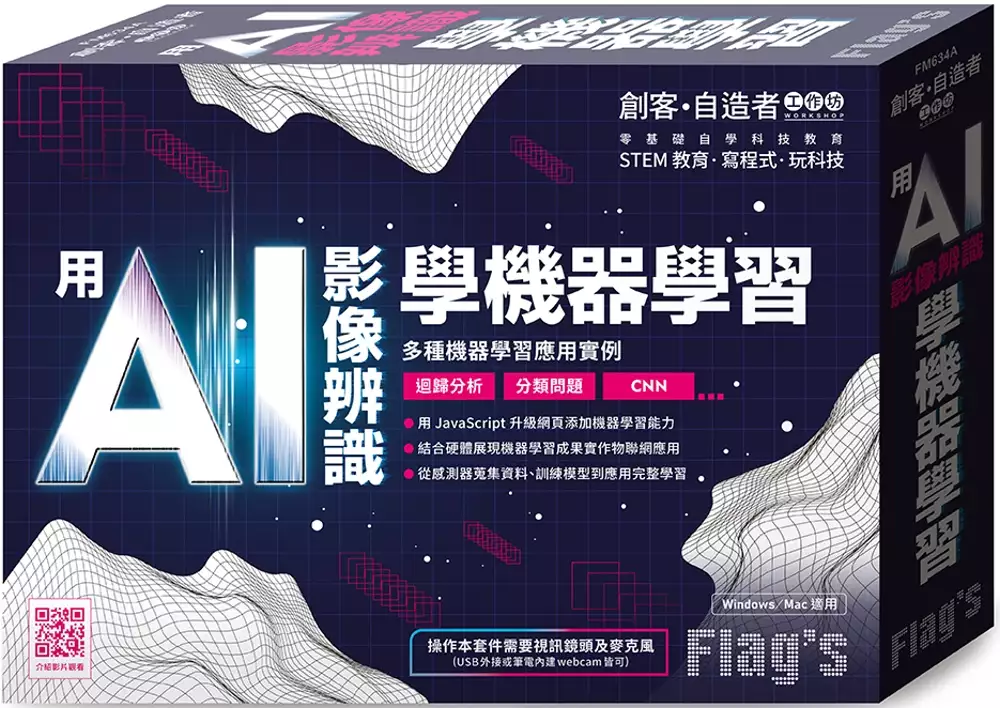

Flag’s 創客‧自造者工作坊 用 AI 影像辨識學機器學習

為了解決視訊鏡頭 的問題,作者施威銘研究室 這樣論述:

不同於常見機器學習皆是由 Python 語言實作, 本書使用 JavaScript 語言於瀏覽器實作機器學習, 搭配著名的 JS 機器學習函式庫 ml5.js 可以更快速且便利地達成 AI 網頁應用, 對於許多熟悉 JS 語言的前端工程師或使用者更為親近, 實驗過程使用 p5.js 程式庫, 讓沒有太多程式設計基礎的使用者也可以更輕鬆將結果視覺化, 再搭配使用 p5.js web editor 線上開發環境, 只需要使用瀏覽器就可以開始輕鬆設計網頁, 不需要在自己的主機建構繁瑣的開發環境, 再搭配 Python 編寫控制板程式, 將應用結合至感測器或實體輸出裝置, 實現更完整的機器學習

應用實例。 本書一開始會先介紹機器學習概念與 p5.js web editor 線上開發環境基本操作, 接著直接體驗使用 ml5.js 中的現有模型, 實作可以辨識特定物件的影像分類器。 除了網頁實作神經網路外, 可再串連硬體控制板, 藉由控制板輸出預測結果, 比如使用物件偵測來判斷是否有人出現, 對應的 OLED 顯示器模組就會出現迎賓文字或相關訊息;或是語音辨識讓玩家用語音來控制遊戲, 遊戲結束後會通知控制板啟動振動馬達回饋給玩家。 最後會使用 ml5 程式庫實際訓練自己的神經網路模型, 首先為利用控制板蒐集感測器資料, 再透過神經網路訓練解決迴歸問題, 如藉由溫度

感測器的訊號, 找出感測值與實際溫度的關係, 做出自製即時電子溫度計, 再結合可以即時顯示畫面去背效果的 U-Net 模型, 就可以使用環境溫度來改變虛擬背景特效。 接著為解決分類問題的神經網路, 使用現成的 Facemesh 模型找出臉部特徵點, 分別蒐集臉部不同的角度資料進行訓練, 最終得到一個可以辨識是否打瞌睡的模型, 再串接實體蜂鳴器在打瞌睡時, 發出警報聲提醒使用者。 最後訓練的神經網路為卷積神經網路, 透過蒐集配戴口罩與否的不同照片作為訓練資料, 經過卷積神經網路訓練後, 就可以用此模型來判斷畫面中的人是否有正確配戴口罩, 再結合模擬門鎖的伺服馬達, 建構出一套口罩

門禁系統的概念。 本產品除實驗手冊外,實驗過程中有任何問題或是建議都可以在 Facebook 粉絲專頁《旗標創客‧自造者工作坊》中留言,即有專人為您服務。 本產品 Windows / Mac 皆適用 操作本產品需要視訊鏡頭及麥克風 (筆電內建或 USB 外接 webcam 皆可) 本書特色 ● 用 JavaScript 升級網頁添加機器學習能力 ● 結合硬體展現機器學習成果實作物聯網應用 ● 從感測器蒐集資料、訓練模型到應用完整學習

應用影像辨識技術於PU滾輪灌注瑕疵檢測之研究

為了解決視訊鏡頭 的問題,作者吳振豪 這樣論述:

傳統製造業的品管檢驗,普遍都是人工檢驗進行篩檢審核,再藉由人力挑出瑕疵品,藉由人力篩檢審核是相當費力的工作,特別是PU滾輪裡的氣泡表面。本研究使用YOLO神經網路框架,運用YOLOv4-tiny輕量化模型作氣泡表面瑕疵分類模型,針對辨識率調整參數及優化,經過實際測試後,分析各方法所適用之硬體設施及使用狀況。實驗部份,經由儀器實際的即時檢測PU滾輪表面的氣泡瑕疵,再透過模型訓練及測試集的成果,辨識結果可達平均精度均值99.4%,最後以最佳數據來實際運用,發現可成功辨識PU滾輪表面的細小氣泡瑕疵。

視訊鏡頭的網路口碑排行榜

-

#1.網路攝影機在Windows 中無法運作

我的攝影機影像昏暗、粗糙或模糊。 我無法使用Microsoft Teams、Skype 或Zoom 進行視訊通話。 請遵循以下快速步驟來修正網路攝影機問題 ... 於 www.dell.com -

#2.視訊攝影機/視訊鏡頭 - PChome 24h購物

智能美顏,通話清晰,遠距教學視訊會議必備! UniSync 2K超高畫質USB智能美顏燈網路視訊直播攝影機廣角款. $799. $899. 於 24h.pchome.com.tw -

#3.請益居家工作視訊鏡頭開啟

最近找工作傾向WFH,有一份居家工作的要求上面寫著:遠距辦公連線時,要保持視訊鏡頭開啟,這樣公司的人會隨時看有沒有在辦公嗎? 於 www.dcard.tw -

#4.視訊鏡頭Webcam丨視訊會議必備

WFH視訊會議必備,高畫質1080P讓你會議品質最高提升,智選家嚴選品牌EMEET、AnkerWork..等,幫助你在視訊會議WFH都順利穩定。具備自動對焦、定焦功能,超廣角FOV視場 ... 於 www.witsper.com -

#5.視訊攝影機| .電腦週邊商品推薦| E-books 官方旗艦店線上購

E-books 官方旗艦店線上購提供視訊攝影機相關優惠與推薦商品價格可供挑選,線上選購.電腦週邊相關商品輕鬆簡單,更多視訊攝影機就在E-books 官方旗艦店線上購. 於 shop.ebooks-cct.com.tw -

#6.視訊鏡頭- ANKER台灣官方網站

全品項(1). 視訊鏡頭(1). 全部最熱銷價格低到高△ 價格高到低▽. GO. 共頁,共筆. 關於ANKER. 關於我們 服務說明 服務據點 媒體報導 聯絡我們. 支援服務. 於 www.anker.tw -

#7.視訊攝影機| 順發線上購物

比較表. Logitech C270 HD 網路攝影機 · 比較表. Logitech C310/120萬HD網路攝影機 · 比較表. UPMOST UCAM-G1 Full HD免驅動視訊攝影機 · 比較表. UPMOST UCAM-G2 2K高畫質 ... 於 www.isunfar.com.tw -

#8.Hawk 360°全景視訊網路攝影機- 產品資訊

逸盛科技所屬二個品牌Esense及Hawk(浩客)。Esense以3C週邊商品為主。Hawk(浩客)是以高階簡報器、耳麥、喇叭為主,Hawk品牌也成功打人中國市場。 於 www.e-sense.com.tw -

#9.【懶人包】遠距上班/上課買這一台視訊攝影機CP值最高?

視訊 攝影機這麼多!原來買這一台最划算?你是居家上班的人,還是遠距教學的老師、學生?還煩惱找不到適合的視訊攝影機嗎?台灣品牌j5create專為各族群量身打造3款視訊 ... 於 www.ubstore.com.tw -

#10.ALC 視訊攝影機

ALC 視訊攝影機. 加入購物車. AWC05 1080P 視訊攝影機. NT$999. NT$699 · 加入購物車. AWC10 2K 視訊攝影機. NT$1,499. NT$990. 關於我們. 公司與品牌介紹 · 投資人專區 ... 於 www.secufirst.com.tw -

#11.視訊鏡頭

POLY Studio P15 視訊會議機-福利品POLY Studio P15 視訊會議機POLY Studio P5 視訊麥克風POLY Studio R30 視訊 ... 視訊鏡頭. 視訊鏡頭. 共5 件商品. product_image. POLY ... 於 www.farwide.com.tw -

#12.視訊鏡頭

視訊鏡頭. 篩選條件. 全部, AnkerWork · 視訊鏡頭. 排序方式. 精選, 暢銷度, 依字母順序(由 ... 視訊鏡頭 · 會議麥克風. 藍牙音頻. 真無線 · 耳罩式 · 藍牙喇叭 · 耳機配件 ... 於 www.soundcore.com.tw -

#13.【高清隨插即用!電腦視訊鏡頭】內建麥克風 ...

【高清隨插即用!電腦視訊鏡頭】內建麥克風電腦鏡頭視訊鏡頭網路鏡頭網路上課鏡頭. 87折. 券後低至. $272/入. $370 /入. 48入大省方案. $322/入. 1入輕量方案. 於 www.pcone.com.tw -

#14.視訊攝影機– new-tw-j5create

視訊 攝影機. Refine By. View As. 6 Products. Close. Refine By. Product Type. 視訊攝影機. Apply. Show results (6) Apply All. JVU368 360° AI智慧全景視訊會議 ... 於 tw.j5create.com -

#15.網路視訊攝影機1080P 電腦視訊鏡頭內建麥克風USB電腦鏡頭 ...

全館滿199 免運. 網路視訊攝影機1080P 電腦視訊鏡頭內建麥克風USB電腦鏡頭網路攝影機電腦攝像頭網路鏡頭. 商品編號:P0116600170853. 原始貨號:P0116600170853. $ 890. 於 mall.iopenmall.tw -

#16.網路攝影機,資訊周邊,電腦資訊

Horus 高畫質網路攝影機麥克風HWUM21. Amazon 暢銷品. $890. JLab EPIC CAM 2K 高畫質網路攝影機WEPICCAMRBLK124. 可客製化視訊畫面. $3,580. JLab JBUDS CAM FHD 高畫質網 ... 於 ec.elifemall.com.tw -

#17.HP 降噪視訊攝影機

HP降噪視訊攝影機具有強大降噪功能不擔心視訊通話於吵鬧環境聲音被干擾適合線上教學網路直播視訊會議視訊通話防疫期間居家辦公好幫手. 於 www.mufu.com.tw -

#18.Webcam推薦:2023年6款超高人氣視訊鏡頭推薦!

市面上webcam視訊鏡頭這麼多,到底要從何挑起?本文從視訊鏡頭的選購要點,到我們精心挑選的webcam視訊鏡頭推薦,全部都會揭露給你,幫助你可以選擇到 ... 於 sound3c.com -

#19.【u-ta】免驅動USB高清視訊鏡頭M9(視訊會議必備)

2.視訊鏡頭可能會有少許色偏差異。 3.在不影響功能及參數下若有變動以收到實際商品為準。 保固範圍 3個 ... 於 711go.7-11.com.tw -

#20.VC300 /VC1000 光學變焦PTZ視訊會議攝影機

「Nugens VC300/VC1000 PTZ視訊攝影機」採用全新210萬像素3倍光學變焦高清鏡頭圖像還原度高,真正1080P優質圖像(1920*1080解析度),超大廣角,視角可達100度無畸變,無需 ... 於 nugenstech.com.tw -

#21.如何用手機鏡頭當成電腦鏡頭及麥克風使用

如果剛好沒有麥克風跟視訊鏡頭,要如何與學生線上同步教學呢? 桌機至iVCame官網(https://www.e2esoft.com/ivcam/) 下載軟體. 手機下載iVCame app. ios版:https://apps ... 於 www.ssps.ntpc.edu.tw -

#22.視訊/網路攝影機- 電腦週邊- 搜尋商品

視訊 /網路攝影機光華商場網路商城. 於 www.gh3c.com.tw -

#23.三星發表平價旗艦Galaxy S23 FE 新FE 平板、耳機同步亮相

而鏡頭規格,則包含1000 萬畫素視訊鏡頭,以及由5000 萬畫素廣角鏡頭、1200 萬畫素超廣角鏡頭與800 萬畫素長焦鏡頭組成的主相機,並且提供Pro Mode 拍攝模式,讓使用者 ... 於 m.eprice.com.tw -

#24.在Mac 上將iPhone 用作網路攝影機

繼續視訊或音訊:在iPhone 上,點一下「繼續」,或按下側邊按鈕或睡眠/喚醒按鈕來將其鎖定。 停止將iPhone 用作網路攝影機或麥克風:在Mac 上結束App。 將iPhone 從選項中 ... 於 support.apple.com -

#25.電腦視訊鏡頭的價格推薦- 2023年10月| 比價比個夠BigGo

電腦視訊鏡頭價格推薦共6312筆商品。包含5963筆拍賣、237筆商城.「電腦視訊鏡頭」哪裡買、現貨推薦與歷史價格一站比價,最低價格都在BigGo! 於 biggo.com.tw -

#26.巨匠線上真人

可以根據自己空閒的時間選擇時段,上課也不用開視訊鏡頭 · 王芷芸韓語. 考取韓語檢定TOPIK 5級. 利用下班時間上韓語課,多餘的點數還可以報名其它語系課程 · 邢靜宜日語. 於 www.abconline.com.tw -

#27.視訊攝影機| HP® 惠普台灣原廠購物網

HP惠普高畫質數位機車行車記錄器m550 · HP惠普雙鏡頭降噪視訊攝影機w600. 於 www.hpgo.tw -

#28.請推薦遠端會議視訊鏡頭

#請推薦遠端會議視訊鏡頭 ... 哭上週別組的同事直接確診.... (先說我PCR陰性唷!!!!) ... 以上這三台!!結束!!! ... Iriun Webcam這套軟體看到有影片 ... 於 www.mobile01.com -

#29.1080P網路攝影機視訊鏡頭

... 視訊鏡頭!【商品特色】☆最高可支援1080p解析度.高清鏡頭.還原色彩☆USB隨插即用.免安裝☆線上教學.會議.google meet ,facebook直播,youtube直播,LINE視訊,skype視訊 ... 於 www.dtaudio.tw -

#30.xiaomi-smart-camera-c400 - 小米官網

400 萬像素攝影機拍出2.5K 超清晰視訊Xiaomi 智慧攝影機C400 更新為解析度 ... 由於結合6P 鏡頭,這款攝影機可有效減少光折射。因此影像無比清晰,就如同您在現場親眼 ... 於 www.mi.com -

#31.視訊鏡頭

720p、1080p、4K畫質因應不同需求使用專為直播主、講師、教師,美國ADESSO 艾迪索品牌台灣製造生產,提供政府、公家機關、企業、國軍等需求;標案詢價. 於 www.apex-inno.com -

#32.「視訊鏡頭」與「頭戴式無線耳機麥克風」操作說明 - 教務處

教務處 Department of Academic Affairs · 「視訊鏡頭」與「頭戴式無線耳機麥克風」操作說明. 於 daa.cpu.edu.tw -

#33.視訊攝影機 - Prosway-博威電通總代理

獨創雙鏡頭子母畫面設計. NT$2,990. 缺貨中. 1 · 2. 關閉. 查看內容 · HP 惠普W500 降噪視訊攝影機. 視訊會議淨噪神器. NT$1,490. 關閉. 品牌分類. 於 www.prosway.com.tw -

#34.視訊攝影機

1080P網路攝影機視訊鏡頭麥克風webcam 電腦攝影機電腦鏡頭電腦攝像頭直播開會上課. $459; 適用折價券. Mr.U優先生【1080P USB視訊鏡頭/網路攝影機】電腦視訊鏡頭. $379 ... 於 ecshweb.pchome.com.tw -

#35.視訊攝影機_最暢銷推薦40款(spm) - honeymanor

祝福! 1080P網路攝影機視訊鏡頭麥克風webcam 電腦攝影機電腦鏡頭電腦攝像頭直播開會上課聆翔旗艦店. 於 honeymanor.com -

#36.Webcam視訊攝影機|網路設備/智慧居家|會員獨享好康折扣活動

推薦各類Webcam視訊攝影機(網路設備智慧居家)商品,包括:ADESSO艾迪索,aibo鈞嵐,AMORE,AVerMedia圓剛,EBooks,EMEET,Jinpei錦沛,JLab,Logitech羅技,Promate ... 於 www.etmall.com.tw -

#37.即時影像監視器:台灣路況即時影像、旅遊景點天氣觀測

即時影像監視器網站提供台灣各地旅遊景點、市區道路、省道、國道高速公路等CCTV 閉路電視攝影機即時影像,免費提供民眾隨時查看交通路況、天氣資訊以及旅遊景點人潮 ... 於 tw.live -

#38.啟動網路視訊鏡頭後顯示灰色和顯示無法使用的相機圖示

關閉使用Skype等相機的所有應用程式,然後重試。 附加訊息. 如果相機在Lenovo Settings意外停用,可能還會遇到此故障。請搜索 ... 於 support.lenovo.com -

#39.視訊鏡頭優惠推薦-2023年10月

你絕對不能錯過的網路人氣推薦視訊鏡頭商品就在蝦皮購物!買視訊鏡頭立即上蝦皮視訊鏡頭專區享超低折扣優惠,搭配賣家評價線上網購視訊鏡頭超簡單! 於 shopee.tw -

#40.視訊鏡頭

視訊鏡頭 · 【Jinpei 錦沛】1080p FHD 高畫質網路攝影機視訊鏡頭視訊攝影機(JW-01B) · 【圓剛】PW310P 1080P 自動變焦網路視訊攝影機(鏡頭遮蓋) · 【聆翔】1080P網路攝影機 ... 於 www.momoshop.com.tw -

#41.視訊中如何切換前後鏡頭? | Line視訊的時候,想要給對方看你 ...

Line 視訊 的時候,想要給對方看你眼前的畫面,是不是很容易就會下意識把手機轉半圈,秀給對方看? 不用那麼麻煩!對話框裡這個鍵,按下去一秒就能轉 鏡頭 ! 於 www.facebook.com -

#42.台灣即時影像監視器

本網站蒐集台灣各地即時影像監視器如國道高速公路、快速公路、市區道路、熱門旅遊景點、天氣資訊、即時路況等,免費提供民眾外出旅行的規劃參考。 於 www.twipcam.com -

#43.視訊鏡頭

圓剛Avermedia MINGLE BAR 視訊會議攝影機PA511D. NT$19,900 ; 美洲獅COUGAR CYCLOPS 整合式視訊相機. NT$5,890 ; 圓剛AVerMedia 雙鏡頭網路攝影機PW313D 61PW313D00AE. NT ... 於 www.pcparty.com.tw -

#44.視訊鏡頭| 視訊&網路攝影機日本橋3C

USB網路視訊攝影鏡頭自動對焦支援2K 華碩ASUS Webcam C3 全高清網路攝影機1080P高畫質自動變焦網路攝影機PW310P 雷蛇Razer Kiyo Pro 清姬專業版桌上型網路視訊攝影機. 於 www.jpb.com.tw -

#45.【2023最新】十大視訊鏡頭推薦排行榜 - mybest

線上會議的普及再加上因疫情影響導致遠端工作者增加,人們對於視訊鏡頭的需求量也跟著提升,而且其不只可用於視訊通話,也有許多YouTube 使用者會用來進行影片直播。 於 tw.my-best.com -

#46.視訊鏡頭

視訊鏡頭 ; S20049, 1/2.8", 8M, 2.81, 2.0 ; S21035, 1/4", 2M, 3.43, 2.0 ... 於 www.calin.com.tw -

#47.視訊鏡頭- 網路攝影機(視訊設備) - 人氣推薦- 2023年10月

視訊鏡頭 網路推薦好評商品就在露天,超多商品可享折扣優惠和運費補助。『開立發票』贈防偷窺蓋1080P高清電腦視訊鏡頭免驅動即插即用內建麥克風網路攝影機攝像頭1080P網 ... 於 www.ruten.com.tw -

#48.改善視訊和音訊體驗- 電腦- Google Meet說明

裝置電量過低; 可用的數據傳輸量有限; 其他品質問題. 變更攝影機或視訊解析度. 在網路瀏覽器中開啟 ... 於 support.google.com -

#49.視訊鏡頭

視訊鏡頭 ; Stream Cam 直播攝影機(黑/白). $3,390 ; BRIO 500 網路攝影機 · $3,590 ; BRIO 300 網路攝影機. 從 $1,790 ; C922 PRO STREAM 網路攝影機. C922 PRO STREAM 網路 ... 於 store.logitech.tw -

#50.網路攝影機- 原價屋Coolpc

華碩ROG EYE S視訊鏡頭。 NT$3,490. 大特賣. 為了你的健康,我能習慣遠距離!Creative防疫組合包限量優惠。 NT$2,280 NT$1,890. 【原價屋送啦】【618懶人包】神龍許願!買 ... 於 www.coolpc.com.tw -

#51.電腦視訊鏡頭- 佳威科技有限公司

全系列電源供應器電腦機殼電子週邊熱賣中. Close. 首頁. HOME · 公司簡介. ABOUT +. 關於我們 · 當月促銷活動. ON SALE · 最新商品. NEW +. 服務項目分類1. 於 jawin.com.tw -

#52.使用Canon 相機進行居家辦公及遠距教學EOS Webcam ...

... 視訊鏡頭通常只是「附屬品」的概念,在這部分不會下太多成本,以至於這樣的鏡頭無法呈現較好的畫質於視訊畫面上。 拿出你的Canon相機來視訊吧! 因為 ... 於 tw.canon -

#53.視訊攝影機

視訊 攝影機. 加入購物車. VB-CAM-201 All-in-one 4K 超廣角視訊會議攝影機. NT$39,000 · 加入購物車. VB-CAM-002 FHD 高畫質防窺網路攝影機. NT$6,990. NT$3,250. 篩選. 於 www.shop.viewsonic.tw -

#54.【免費下載】最佳10款Windows 10 視訊鏡頭錄影軟體

因此,當您在Windows 10電腦上工作時,需要使用正確的Windows 10視訊鏡頭錄影工具來錄製直播串流影片、螢幕畫面或Skype聊天,並取得高品質影像和影片。網路上有大量具有進 ... 於 recorder.easeus.com -

#55.Lightroom Classic 中的鏡頭模糊

Premiere Pro 視訊編輯和製作 · Adobe Stock 可授權的高品質資產 · 檢視所有 ... 常見於反光或反射式鏡頭,也稱為「甜甜圈」。 貓眼. 通常是由特定鏡頭的 ... 於 helpx.adobe.com -

#56.測試您的視訊

概觀在加入會議之前,您可以使用Zoom 測試視訊攝影機,以確認攝影機可正常運作。 以下步驟將引導您手動測試視訊。 您也可以開始測試Zoom 會議。 於 support.zoom.us -

#57.Elgato FACECAM 網路攝影機視訊鏡頭

Elgato FACECAM 網路攝影機視訊鏡頭 · 商品型號 · 商品條碼 · 商品價格 · 商品數量 · 付款與運送 7-11便利商店 全家便利商店 LINE Pay 刷卡(卡片) ATM · 分期資訊 · ADD PRODUCT加 ... 於 www.inpad.com.tw -

#58.資訊組| Yealink CP960 視訊鏡頭及麥克風組使用說明

資訊組| Yealink CP960 視訊鏡頭及麥克風組使用說明| 資訊組. 於 www.cogsh.tp.edu.tw -

#59.AVer 台灣| 圓展科技

AVer Information 圓展科技擁有智慧教育與視訊會議系統兩大產品線,提供實物攝影機、充電車、教學互動軟體、遠距教學錄播系統等產品、安全監控,研發點對點及多點視訊 ... 於 tw.aver.com -

#60.網路攝影機完全攻略

攻略. 視訊畫質; 鏡頭角度; 更新率; 內建麥克風; 隱私鏡頭蓋; 自動對焦; 實物投影; 軟體支援; 產品一覽表. 隨插即用,連接到電腦或筆電就能進行連線視訊,或影像錄製的網路 ... 於 www.avermedia.com -

#61.孕妻宮縮視訊開會楊祐寧直呼太扯

... 視訊開會,祐祐不敢置信:「好扯喔!」 ... 夫妻倆趁著二寶來報到前,把握機會帶大女兒Anah出去玩,享受最後的三人時光,一切甜蜜生活都在祐祐的鏡頭下分享 ... 於 www.cdns.com.tw -

#62.Webcam網路攝影機(VR / USB / 電腦週邊)

【wifi款】領夾式微型攝影機可連接手機查看循環錄影隱藏鏡頭130°廣角磁吸背夾紅外線夜視密錄器行車紀錄器. $979 · Coolpo PANA AI 360全景4K網路視訊會議攝影機系統. 於 tw.buy.yahoo.com -

#63.【筆電實用教學】如何透過MSI軟體快速開啟視訊鏡頭

防疫期間在家時間更長了,不論是遠距會議或線上學習,使用到視訊鏡頭的機會也大大增加。使用MSI筆電時,你可以透過MSI軟體快速地開啟視訊鏡頭, ... 於 tw.msi.com -

#64.視訊鏡頭

遠距教學居家辦公 > 遠端辦公必備 > ├ 視訊鏡頭 · 優先推薦 價格低至高 價格高至低 · E-books W11 網路高畫質LED補光攝影機. 網路價$699 ... 於 www.tk3c.com -

#65.GoPro 品牌旗艦館

超有感進化! [ 教學] 如何將你的GoPro成為視訊鏡頭How to use GoPro as. icon-plus [ 教學] 如何將你的GoPro成為視訊鏡頭How to use GoPro as Webcam · [ 教學] 更新超有 ... 於 www.pchomeec.tw -

#66.網路攝影機1080P 視訊鏡頭麥克風網路攝影機

滿足各種場景;超大廣闊視角;網路視訊鏡頭USB即插即用;視角可自由調整;免驅動即插即用;內置數字麥克風;高清1080P;內置8米全指向性吸音降噪麥克風通話清晰,輕鬆語音聊天; ... 於 www.books.com.tw -

#67.磁吸式視訊攝影機| VG-STCBU2K/ZW | 台灣三星電子

磁吸式視訊攝影機(VG-STCBU2K/ZW) - 透過台灣三星電子了解更多產品的功能與特色,並找到最符合你需求的電視配件。 於 www.samsung.com -

#68.無線視訊鏡頭- FindPrice 價格網2023年10月精選購物推薦

無線視訊鏡頭的推薦商品價格,還有更多《飛翔無線3C》Insta360 Link AI智能4K網路攝影機◉公司貨◉人臉自動追蹤◉視訊鏡頭◉極速對焦相關商品比價, ... 於 www.findprice.com.tw -

#69.2023年必買視訊鏡頭排行榜,挑戰市場最低價!

為您精選2023年網友推薦的視訊鏡頭!限時超殺優惠,再猶豫就要撲空了!快到生活市集搶購! 於 www.buy123.com.tw -

#70.Acer 高畫質視訊攝影機

Acer 高畫質視訊攝影機. Full HD 1080P 高畫質視訊影像. 建議售價. NT$1,260. 商品 ... 攝影機鏡頭:1/2.7 “ CMOS感光元件. 影像解析度:1920H x 1080V@ 60fps. 視野角度 ... 於 www.acergadget.com -

#71.視訊會議不夠美?原來是鏡頭高度放錯了

因應許多人開始在家工作,遠距開會、線上會議成了上班族的日常,要如何面對視訊鏡頭又美又上相? 於 www.cw.com.tw -

#72.【2023精選】視訊鏡頭推薦:線上會議必備的網路攝影機推薦

【網路攝影機和監視器一樣嗎? · 網路攝影機推薦:有抗噪麥克風的「羅技C270 HD」 · 高畫質視訊鏡頭:E-books W16 隨插即用網路攝影機 · SKYPE認證視訊鏡頭:微軟LifeCam HD- ... 於 www.myfeel-tw.com -

#73.【網路攝影機推薦】5款高CP值視訊鏡頭!遠距教學、視訊會議

視訊, 鏡頭, 電腦, 內建麥克風, 網路攝影機, 廣角, 高解析度, Camera, 高清畫素, Webcam, 網路視訊攝影機 ; 羅技C310 HD, 對角視野60°, HD 720P ; 宇晨IF- ... 於 kikinote.net -

#74.首頁» 網通儲存» 視訊攝影機- 三井3C購物網- 行動版

三井3C購物網販售筆電、電腦、週邊耗材與3C家電,提供美好的購物經驗。會員首購送$100,享回饋金折扣。生活家電、數位商品應有盡有,划算價格,快速到貨,滿意保固, ... 於 www.sanjing3c.com.tw -

#75.網路攝影機| Microsoft 配件

有了Microsoft LifeCam 網路攝影機產品,您不必再打字,只要開口說話就可以了。您不但能看見家人和朋友的笑容,還能享受清晰的視訊品質與銳利的靜態相片。 於 www.microsoft.com -

#76.視訊鏡頭 - 全家行動購

運動鏡頭車用鏡頭鏡頭攝影機高畫質攝影機asus 電腦降噪電腦USB 攝影機車用電腦asus 鏡頭運動攝影機. 你正在看. 視訊鏡頭. 分類. -. 排序. 最新上架. 共2 項商品. 於 mart.family.com.tw -

#77.8個如何挑選最合適的視訊會議攝影機重點(Google Meet ...

自動人像取景(Auto Framing):; 自動追蹤攝影機(Auto Tracking):. – 與Google Meet, Teams, WebEx 視訊會議解決方案配合使用? – ... 於 cave-tek.com -

#78.單視角2D影像深度資訊不漏接平面影像重建3D立體視覺(2)

具有多鏡頭(Shots)和多場景(Scenes)的2D視訊影片,也能應用單視角的線索(Cue)和偵測技術,獲得在2D視訊影像內每個物件的深度資訊。 視訊分鏡偵測. 由於 ... 於 www.mem.com.tw -

#79.狼性!2官員忘關鏡頭「辦公室做愛大放送」 影片瘋傳被停職 ...

【劉育良/綜合報導】中國山東省濰坊市2名基層官員,日前在視訊會議後忘了關閉鏡頭,然後就在辦公室內做愛,過程除了播放給與會眾人觀看, ... 於 tw.nextapple.com -

#80.2023視訊鏡頭推薦,平價又好用的視訊鏡頭在這裡!

視訊鏡頭 推薦1:【Logitech 羅技】C310 HD 網路攝影機 · 視訊鏡頭推薦2:【圓剛】PW310P 1080p 高畫質自動變焦網路攝影機 · 視訊鏡頭推薦3:【WIDE VIEW】免驅動HD高清360°視訊 ... 於 fashionculturetaiwan.com -

#81.網路攝影機/視訊鏡頭/吹風機< 3C家電/週邊- 光南大批發

在PChome商店街共有7 件網路攝影機/視訊鏡頭/吹風機相關類別商品,您想找的是【光南大批發】《免運費》logitech羅技C270 HD WEBCAM 網路攝影機視訊鏡頭商品嗎? 於 www.pcstore.com.tw -

#82.高CP視訊鏡頭推薦4+|到底需不需要用高畫素的視訊攝影機 ...

高CP視訊鏡頭推薦4+|到底需不需要用高畫素的視訊攝影機(webcam)? Carscam HD 推薦視訊鏡頭_. 更新日期:2021-10-05. 當疫情突然擴大,人人都努力防疫的時候,在家 ... 於 www.carscam.com.tw -

#83.視訊召開區分所有權人會議範例(建議)

第十點召開視訊區權會中選舉或議案之投票起迄時間及其決議結果,皆. 由主席宣布,經主席認為其有清點人數之必要,請區分所有權人. 將視訊鏡頭開啟,並以1.□舉手或是2 ... 於 www.publicwork.ntpc.gov.tw -

#84.大同大學數位學習+ - 無法啟用視訊鏡頭

若您在Chrome瀏覽器使用Google Meet時,無法啟用視訊鏡頭. 請嘗試調整瀏覽器安全連線設定或及電腦鏡頭隱私權設定. 瀏覽器安全連線設定. 連入會議室連結後 於 sites.google.com -

#85.視訊鏡頭彙整

... 鏡頭視訊攝影機. 【POLY STUDIO E70-4K智能雙鏡頭視訊攝影機】 專為大型會議室設計,讓每個與會人員都仿佛置身於同一個會議室內。 採用4K+傳感器的雙鏡頭設計 附有 ... 於 www.hualiteq.com -

#86.ASUS Webcam C3|串流媒體

... 視訊; 有效減少環境噪音以提供清晰的視訊通話,甚至是在遊戲過程中; 可調整俯仰角度的90° 固定夾適用於各種筆電螢幕與桌機顯示器,360° 旋轉機構可提供彈性的攝影機角度 ... 於 www.asus.com -

#87.2023推薦最佳6款視訊鏡頭攝影機|羅技Logitech、EMEET ...

視訊鏡頭 就是要簡單好用,所以一定要找隨插即用免驅動,如果同時有程式可以控制更好,因為每個品牌預設值都不一樣,加上每個人對於顏色喜好也不同,所以如果支援程式調整是 ... 於 techteller.com -

#88.官方HP® 驅動程式和軟體下載| HP®顧客支援

觀看視訊. #pps_lbl_Modal_HPLogo. 查找產品標籤以找尋您的序列號。 產品資訊標籤含有序列號及產品編號。 可在筆記型電腦背面、電池盒裡面或筆記型電腦背面的蓋子上找尋 ... 於 support.hp.com -

#89.視訊鏡頭| 購買最優惠視訊會議或在家工作用網路攝影機

Wellent售賣各大品牌的視訊會議或在家工作用視訊鏡頭及網路攝影機,Logitech、Rapoo,助你比較各型號的價格、性能,找到心儀產品。價錢實惠,香港行貨,提供門市取貨或 ... 於 www.wellent.com -

#90.ELGATO 視訊鏡頭| 主機/鏡頭商品推薦

CSEmart提供ELGATO 視訊鏡頭相關優惠與推薦商品價格可供挑選,線上選購主機/鏡頭相關商品輕鬆簡單,更多ELGATO 視訊鏡頭就在CSEmart. 於 www.csemart.com -

#91.LG Smart Cam 智慧視訊鏡頭| LG 台灣

獲取有關LG VC23GA的信息。查找有關LG VC23GA Smart Cam 智慧視訊鏡頭的圖片,評論和技術規格. 於 www.lg.com -

#92.選購必看!視訊鏡頭的四大迷思指南

讓我們輕鬆探討關於視訊鏡頭的常見迷思,幫助大家在選購、推薦視訊鏡頭時更輕鬆聰明!ideaCam 專業拍物視訊鏡頭,解決你的選購困惑。 於 www.benq.com -

#93.視訊攝影機- EcLife良興購物網

AverMedia 圓剛雙鏡頭網路攝影機PW313D · Razer 雷蛇Kiyo X 清姬網路視訊攝影機 · Logitech 羅技BRIO 4K HD 網路攝影機 · 【福利精品】ANKER PowerConf C300 1080P視訊攝影機. 於 www.eclife.com.tw -

#94.RAZER視訊鏡頭 - 鍵盤滑鼠墊電競椅

RAZER視訊鏡頭 · RAZER 雷蛇Kiyo Pro 清姬專業版Webcam 桌上型網路直播 · RAZER Kiyo X 清姬視訊攝影機網路攝影機實況直播視訊多種影像設定. 於 www.pchot.com.tw -

#95.視訊鏡頭測試- 線上,免費

您若打開多個使用視訊鏡頭的軟體可能會導致其無法正常運作。 他是如何運作的呢. Click “Start Webcam Test”. 1.點擊「開始視訊鏡頭測試」. 於 www.veed.io -

#96.電腦視訊鏡頭的價格推薦- 飛比有更多監控攝影機商品

電腦視訊鏡頭價格推薦共8789筆。另有電腦視訊鏡頭麥克風、電腦視訊鏡頭推薦、小米攝影機監視器。飛比為你即時比價,全台電商網購價格輕鬆找,一秒為你找便宜, ... 於 feebee.com.tw -

#97.2022精選6款超人氣「電腦視訊鏡頭推薦」,在家遠端工作或 ...

電腦視訊鏡頭推薦6|Logitech C920 HD PRO. Full HD 1080p視訊畫質,擁有78度的鏡頭視野,還有自動光線校正功能,復原最清晰的影像色彩 ... 於 www.popdaily.com.tw -

#98.視訊鏡頭|網路IPCAM

... 攝影機視訊鏡頭遠端教學居家辦公USB隨插即用. NT$988. NT$1,290. 加入購物車 · 米特3C ... 攝影機遠距視訊鏡頭直播居家辦公線上教學. NT$1,488. NT$1,690. 加入購物車 · 米特 ... 於 www.mitte3c.com -

#99.用手機當電腦的Webcam或實物投影機,輕鬆錄製板書或教材

電腦的Webcam或筆電的視訊鏡頭通常只拿來拍攝人臉,不容易用來拍攝板書或是當成實物投影機(架設、取景位置不易),此時我們可以手機的鏡頭跟電腦連線,當成Webcam鏡頭 ... 於 book.whsh.tc.edu.tw